Real oder Fake? Wie ein Forschungsteam aus Erlangen Deepfakes zuverlässig enttarnt

Veröffentlicht am January 27, 2026

Deepfakes, also KI-generierte Bilder oder Videos, lassen sich kaum noch mit bloßem Auge erkennen. Während neue Generatoren in hoher Taktung erscheinen, hinken viele technische Erkennungssysteme hinterher. Sandra Bergmann, Doktorandin an der Friedrich-Alexander-Universität Erlangen-Nürnberg (FAU), forscht deshalb an der automatisierten, robusten Erkennung synthetischer Bildinhalte. Gemeinsam mit Prof. Christian Riess und der secunet Security Networks AG entwickelte sie im Rahmen der SPRIN-D Funke “Deepfake Detection and Prevention“ Innovation Challenge den Prototyp VeriTrue und erreichte damit das Finale.

Bild: © FAU / Giulia Iannicelli

Bild: © FAU / Giulia Iannicelli

Forschung zwischen real und synthetisch

Sandra Bergmanns Forschung bewegt sich an einer der sensibelsten Schnittstellen aktueller KI-Entwicklung: Sie untersucht, wie sich synthetisch erzeugte Bilder von echten unterscheiden lassen; selbst dann, wenn letztere durch KI-basierte Kompression verändert wurden.

Ein zentrales Thema ihrer Dissertation ist JPEG AI, ein neuer Bildkompressionsstandard, der auf neuronalen Netzen basiert. Diese Art der Kompression hinterlässt Spuren, die mit denen von KI-generierten Bildern vergleichbar sind. Genau hier setzt ihre forensische Analyse an.

"Das ist quasi eine Kompressionsmethode, die neuronale Netze nutzt. Die hinterlassen auch ähnliche Spuren wie KI-Bildgeneratoren."

Nicht jedes Bild mit KI-Spuren ist automatisch ein Deepfake. KI-komprimierte Bilder sind ursprünglich reale Aufnahmen – durch neuronale Netze lediglich verändert, nicht generiert. Ihre Forschung zielt deshalb auch darauf, diese Fälle zuverlässig auseinanderzuhalten.

Ein weiterer Forschungsschwerpunkt: Deepfake-Erkennung in praxisnahen Szenarien. In einem dreijährigen Projekt mit der Nürnberger Versicherung arbeitete Sandra an der automatisierten Erkennung manipulierter Schadensbilder. Ein Aha-Moment: Wie schnell und einfach sich mit heutigen Tools ein überzeugender Bild-Fake erzeugen lässt.

Deepfakes als gesellschaftliche Herausforderung

Für Sandra ist klar: Deepfakes sind nicht nur ein technologisches Problem, sondern auch eine gesellschaftliche Gefahr. Die Schwelle zur Erstellung überzeugender Fälschungen ist niedrig und die Verbreitung über soziale Medien rasant.

„Wir leben in einem Zeitalter, wo Social Media komplett normal ist und Inhalte sehr schnell verbreitet werden können, ohne dass man hinterfragt, ob es real oder fake ist.“

Dabei geht es nicht nur um Desinformation in politischen Kontexten. Auch wirtschaftlicher Betrug, etwa durch gefälschte Beweisfotos, ist eine reale Bedrohung. Dass KI-generierte Bilder visuell immer überzeugender werden, erschwert die Einschätzung zusätzlich.

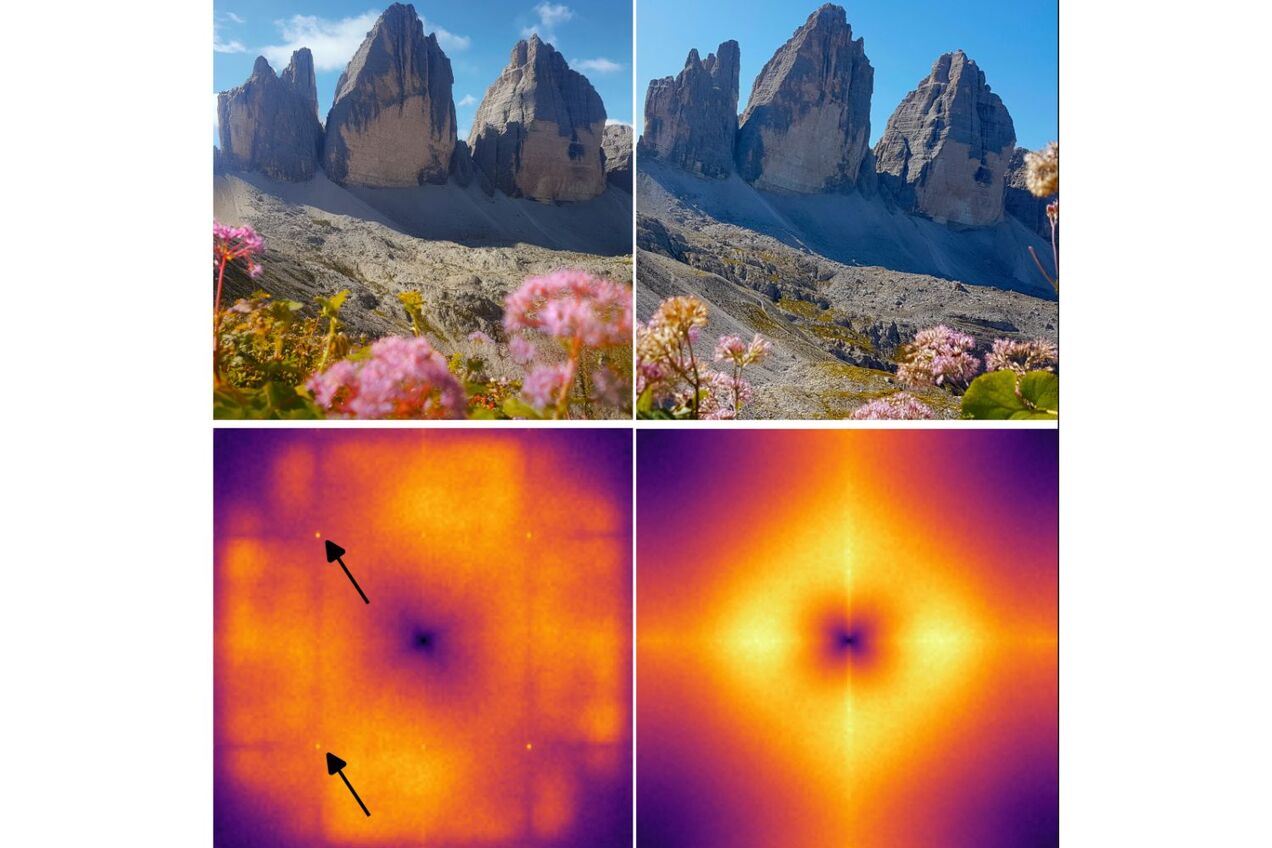

Um zu zeigen, dass auch technisch fundierte Hinweise auf KI-Bilder möglich sind, demonstriert Sandra ein anschauliches Beispiel: ein KI-generiertes Bild der Drei Zinnen (links) im Vergleich zu einem echten Urlaubsfoto (rechts).

Auffällig ist vor allem der Frequenzbereich der Bilder: Während im KI-generierten Bild (Midjourney V7) periodische Peaks im Frequenzspektrum zu sehen sind, ein typisches Artefakt vieler generativer Modelle, fehlen diese bei echten Fotos vollständig.

Solche Artefakte lassen sich zwar nicht mit dem bloßen Auge erkennen, wohl aber durch bildforensische Analyse. Genau das macht diese Methoden so wertvoll – sie liefern technische Belege für Echtheit oder Fälschung, auch wenn die visuelle Täuschung perfekt erscheint. Umso wichtiger sei es, Bildinhalte nicht nur mit dem Auge zu prüfen, sondern technische Nachweise heranzuziehen – oder, im Alltag: Quellen hinterfragen, Kontext prüfen, nicht blind vertrauen.

Bis ins Finale der SPRIND-D Challenge

Im Rahmen der bundesweiten Innovations-Challenge SPRIN-D „Deepfake Detection and Prevention“ entwickelte Sandra gemeinsam mit dem Team der secunet Security Networks AG und der Friedrich-Alexander-Universität Erlangen-Nürnberg (FAU) einen Prototypen zur Deepfakte Detektion. Statt nur auf einen Klassifikator zu setzen, kombiniert der Prototyp mehrere Detektoren, die auf unterschiedliche Aspekte von Deepfakes spezialisiert sind: Einige erkennen typische Merkmale bekannter KI-Bildgeneratoren, andere sind bewusst ohne Deepfake-Vorwissen trainiert, um Ausreißer identifizieren zu können, etwa Bilder aus bislang unbekannten Generatoren. Sandra beschreibt diesen Mechanismus so:

„Wir verwenden mehrere unterschiedliche Detektoren, die auf verschiedene Aspekte spezialisiert sind – manche kennen viele Deepfakes, andere gar keine. So können wir auch neue Generatoren erkennen. Und die ganzen Detektoren werden miteinander intelligent verknüpft, um eine zusammenfassende Entscheidung zu treffen.“

Diese Architektur erlaubt es, auch neue Deepfakes zu erkennen, ohne dass das System zuvor auf entsprechende Trainingsdaten angewiesen ist. So lassen sich etwa große Mengen von Bildmaterial vorsortieren, ohne dass jedes Bild manuell geprüft werden muss – ein echter Vorteil für Behörden oder Versicherungen.

Mit diesem Ansatz schaffte es das Team bis ins Finale der SPRIN-D Challenge. Auch wenn der Hauptpreis nicht gewonnen wurde, war das Projekt ein Erfolg: Der erste Prototyp steht!

Sandra Bergmann studierte Medizintechnik und elektronische und mechatronische Systeme an der Technischen Hochschule Nürnberg Georg Simon Ohm. Seit 2021 ist sie Doktorandin in der Forschungsgruppe Multimedia Security am Lehrstuhl für IT-Sicherheitsinfrastrukturen an der Friedrich-Alexander-Universität Erlangen-Nürnberg. In ihrer Forschung beschäftigt sie sich mit der forensischen Analyse von KI-komprimierten und KI-generierten Bildern. Im Rahmen ihrer Promotion hat sie an einem dreijährigen Projekt zur bildbasierten Betrugserkennung mit der Nürnberger Versicherung zusammengearbeitet. Zuletzt nahm sie am SPRIN-D Funke "Deepfake Detection and Prevention" teil, wo sie gemeinsam mit einem Team von secunet Security Networks AG einen Prototypen zur robusten Deepfake Detektion entwickelte.

Alina Laßen

Werkstudentin Marketing & Projektmanagement

NUEDIGITAL

Ähnliche Blogbeiträge

.png?locale=de)

Feministische KI:Warum Künstliche Intelligenz eine Machtf...

Feministische KI ist kein einzelnes Tool, sondern ein Perspektivwechsel: Wie Macht, Design und Nutzung von KI gerechter gestaltet werden können.

Veröffentlicht am February 19, 2026

Weiterlesen